|

|

|

发布时间: 2019-02-10 |

|

|

|

|

收稿日期: 2018-10-19

基金项目: 国家自然科学基金(61772327)

中图法分类号: TP183

文献标识码: A

文章编号: 1006-4729(2019)01-0077-06

|

摘要

由于眼睫毛等复杂因素的干扰, 虹膜图像中上眼睑的精确定位一直是虹膜识别中公认的难题。如果上眼睑定位不准确, 将会在识别过程中引入大量噪声, 严重影响虹膜识别的准确率。为了获取上眼睑的准确位置, 首先构建了用于分类的神经网络, 借助于滑动窗口, 精确获取了上眼睑的关键点; 然后, 用二次曲线对关键点进行拟合, 得到上眼睑的精确位置。最后, 对该算法进行了评估。结果表明, 该算法具有高准确率和强泛化能力。

关键词

虹膜识别; 眼睑定位; 深度神经网络; 关键点

Abstract

Detecting upper eyelid accurately is considered difficult in iris recognition due to the interference of complex factors such as eyelashes.If the upper eyelid positioning is not accurate, a lot of noise is introduced in the process of recognition, which seriously affects the accuracy of iris recognition.First, a neural network is constructed to precisely locate the upper eyelid.Next, the key points of the upper eyelid are obtained by the network with the help of the sliding window.Then, the exact position of the upper eyelid is obtained by fitting the key points with parabolic curves.Finally, under the strict evaluation criteria, it is proved that the algorithm has high accuracy and strong generalization ability.

Key words

iris recognition; eyelid location; deep neural network; key points

随着生物特征识别的广泛应用, 虹膜识别因其优势受到了前所未有的关注。相关的测试报告指出, 虹膜识别是最精确的生物特征识别手段, 而且虹膜的纹理非常稳定[1-2]。同时, 整个虹膜识别的过程是无侵犯的, 这个特性在很多场景的应用中具有非常重要的意义[3]。精确、稳定、无侵犯这3个特性使得虹膜识别具有广阔的应用前景, 因此研究人员提出了多种方法[4-8]将虹膜识别应用于现实生活。虹膜识别的第一步是实现虹膜图像的精确分割。这需要精确定位瞳孔边缘、虹膜边缘、眼睑、睫毛以及其他一些干扰因素。由于瞳孔和虹膜的形状接近圆形, 很多方法都能较好地定位瞳孔外圆和虹膜外圆。但是对于眼睑的定位, 尤其是上眼睑的定位, 却非常困难, 这是因为眼睑周围有着分布复杂的睫毛、光斑、阴影以及其他干扰, 例如各种类型的双眼皮、化妆产生的眼线、涂抹的睫毛膏等。上眼睑普遍存在于虹膜图像中, 而且经常遮挡着很大部分的虹膜区域。如果眼睑的定位不准确, 将会在下一步的虹膜编码过程中产生大量的噪声。

传统方法都是基于像素间的梯度来实现的, 而梯度很容易受到噪声的干扰, 很难取得好的效果。即使没有干扰, 不同的图像纹理也会有不同的梯度, 即便是在单一的数据库里, 图像的梯度也可能十分复杂, 更不要说将这些方法应用于不同设备、不同人群、不同场景下采集到的多种数据库里。因此, 单一的固定策略很难应对各种不同的场景和复杂的情形, 需要一种自适应的策略来进行眼睑定位。文献[9-11]将Adaboost和Haar-like特征应用于眼睑的定位。但这些方法仍存在一些问题, 例如模型需要利用Canny算子进行预处理, 还需要进行去噪声的后处理, 在困难场景下的表现不尽如人意; 分类器的最终表现严重依赖于特征, 设计好的特征非常困难, 而Haar-like特征无法应对众多复杂的场景。

近年来, 深度卷积神经网络(Deep Convolutional Networks, DCNs)在图像领域[12-16]得到了广泛应用。DCNs非常善于提取特征, 能够在复杂的模式识别任务(如目标分类、定位、检测)中取得重大的突破。2016年, DCNs首次应用于虹膜分割的研究中[17], 其他基于DCNs进行虹膜识别的研究[18-23]出现在2017年, 但上述研究中并没有针对眼睑的定位问题进行深入探讨。文献[22-23]研究了可见光下的图像, 而虹膜识别需要近红外光, 在近红外光下虹膜区域才会出现明显的纹理, 尤其是针对可见光下虹膜颜色较深的亚洲人。文献[17-21]采用全卷积神经网络(Fully Convolutional Networks, FCNs)分割虹膜区域, FCNs[24]在2014年被提出, 并应用于分割任务中。FCNs分割图像时需要像素级别的精确标注, 但这些标注大多很难获得。由于FCNs自身的采样结构, 导致定位的边缘不够精细。

在上眼睑区域, 由于睫毛等因素的干扰, 得到的效果并不理想, 因此本文提出了一种新的方法进行眼睑的精确定位。首先利用DCNs给出眼睑的关键点, 然后采用二次曲线进行拟合, 得到眼睑的精确位置。这种方法仅需要标注几个关键点, 相比于FCNs, 可以大大减少工作量, 且在很多复杂的场景下可以取得很好的效果。

1 深度卷积网络模型和眼睑精确定位方法

1.1 深度卷积网络模型

在计算机视觉中, 有3个基本任务, 从易到难依次为分类、定位、检测。研究人员提出了很多有名的目标检测框架[14], 但这些框架只给出了包含目标的矩形框。

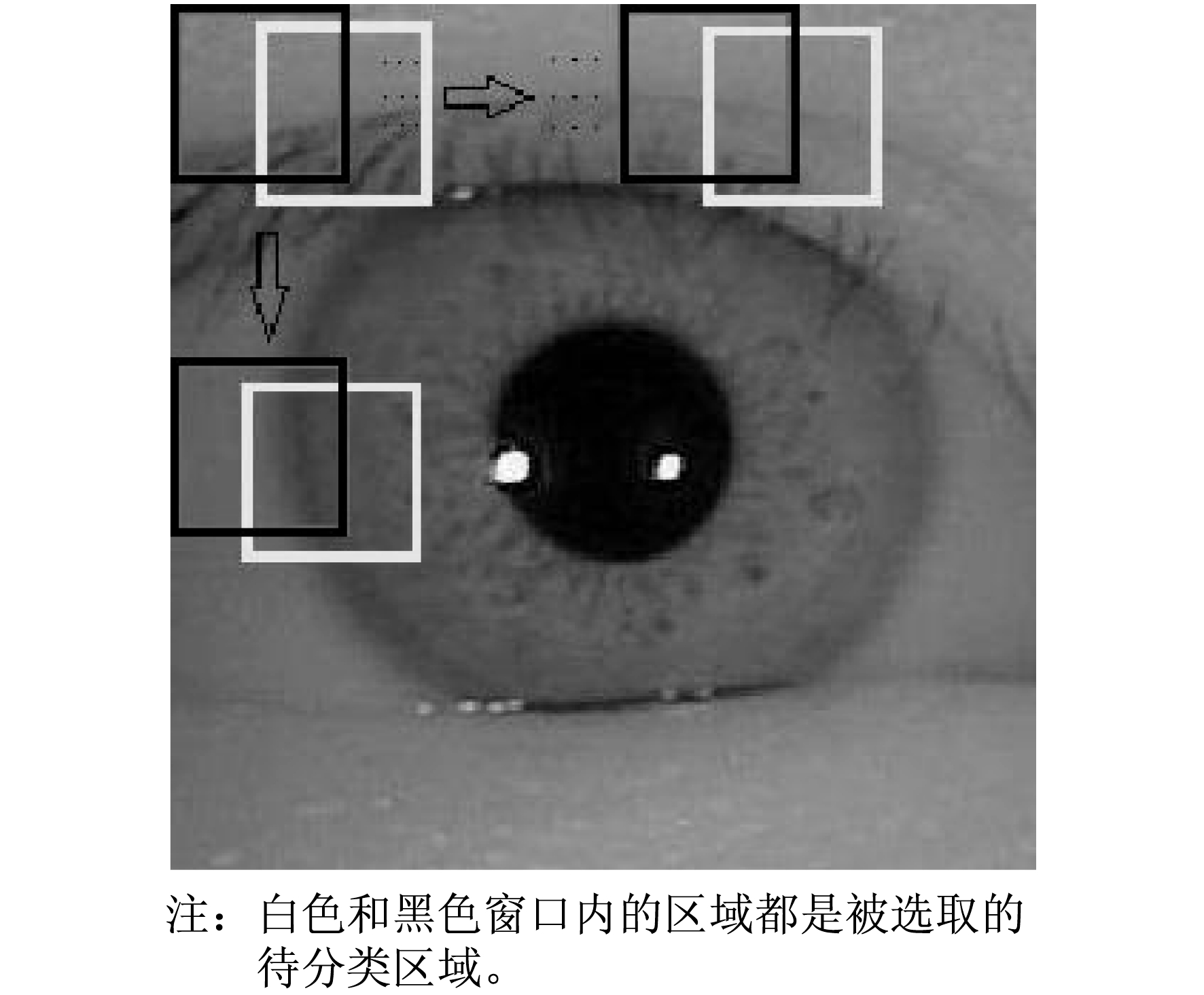

眼睑的定位问题更像是一个图像的语义分割问题, 矩形框并不能满足需要。因此, 一个最简单的思路就是直接借助于滑动窗口将定位任务转化为分类问题, 并给出关键点, 如图 1所示。

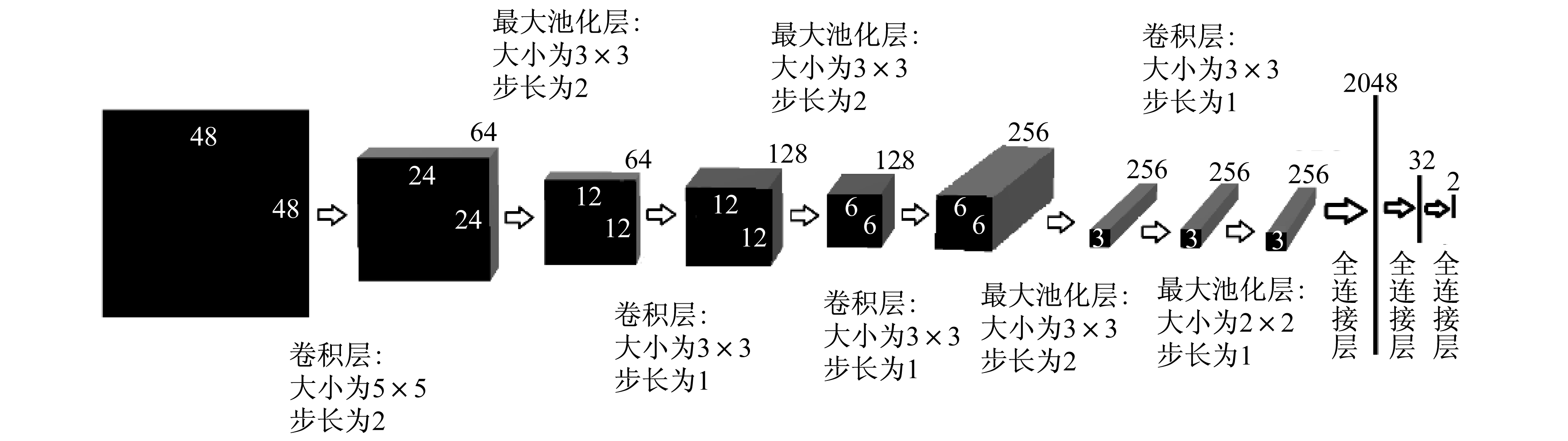

由图 1可见, 利用滑动窗口, 眼睑关键点的定位问题转化为分类问题。对每个窗口进行二分类, 若窗口被分类为眼睑区域, 则将此窗口的中心点定义为眼睑关键点候选点。通过不断进行实验测试, 根据定位精度对比结果, 最终选定适用于眼睑关键点分类的深度卷积网络模型(EyelidNet), 如图 2所示。

1.2 眼睑精确定位方法

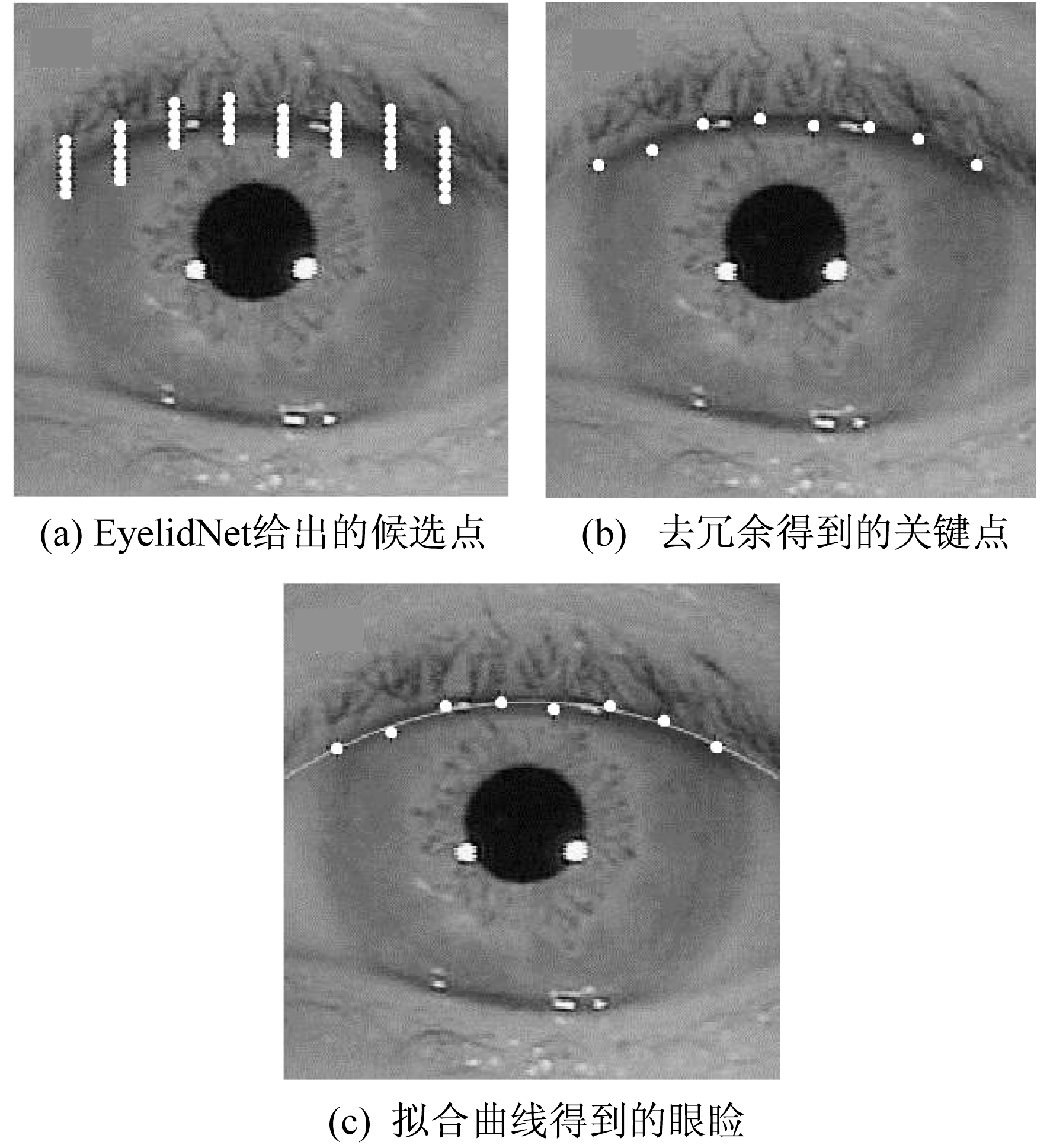

利用EyelidNet分类滑动窗口获取候选点。对于图 2所示的EyelidNet网络, 每一个48×48的滑动窗口, 经过网络推理后都会返回一个二分类的结果。若属于眼睑的类, 则窗口中心点记为眼睑候选点。另外, 不需要对水平和垂直方向上的每个像素进行滑动窗口检测。为了减少定位时间, 滑动窗口垂直方向步长取4像素, 水平方向步长取35像素, 即可取得很好的效果。定位结果如图 3所示。

图 3(a)为实际检测过程中, EyelidNet网络直接给出的眼睑候选点, 可以看出, 网络直接给出的候选点过于冗余。本文对垂直方向上的若干候选点进行平均操作, 得到了最终的眼睑关键点, 如图 3(b)所示。

对于图 3(b)给出的关键点坐标, 采用最小二乘法进行二次曲线拟合, 得到图 3(c)中所示的抛物线。这条抛物线即代表需要定位的眼睑。当然, 直接在图 3(a)的基础上进行拟合也能得到与图 3(c)几乎相同的曲线, 但去除冗余之后更便于人为地观察定位误差。因此本文进行了取平均的操作。

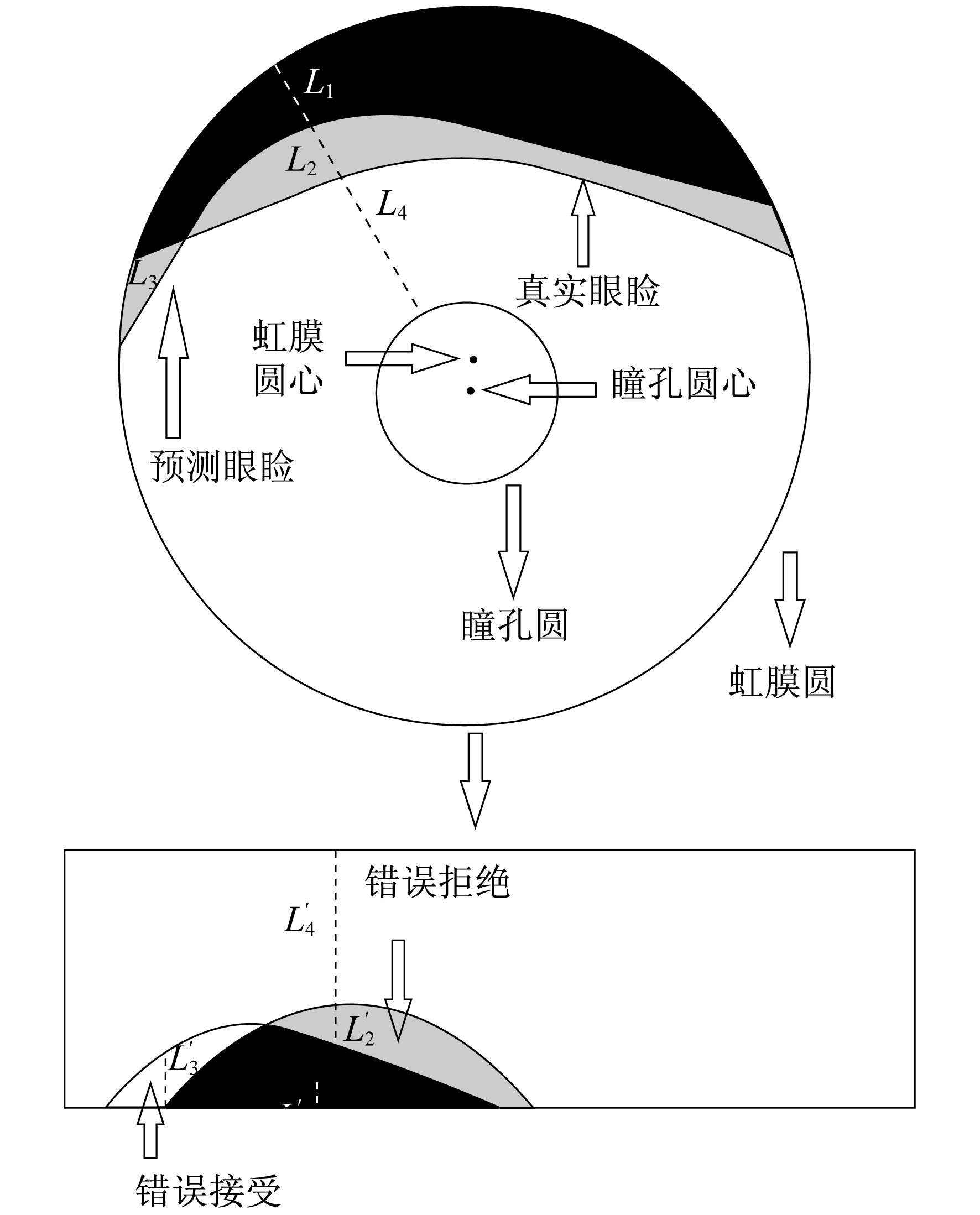

1.3 确定定位精度的度量标准

现有的虹膜识别文献中很少有对眼睑定位方法的单独论述, 也没有建立统一的标准来度量眼睑定位的精准程度, 往往是人工直接评估某一张图像定位是否准确。文献[8]是唯一给出具体的评估眼睑定位标准的文献。该算法在归一化的矩形中评估定位的误差, 在虹膜识别中完成定位后需要将虹膜区域进行归一化, 以适应瞳孔的扩张和图像尺寸的不同。本文采用一般的归一化方法, 以瞳孔圆的圆心为圆心按顺时针方向将虹膜所在的环形区域展开成512×64的矩形, 展开后的结果如图 4所示。

从图 4可以看出, 眼睑定位的误差体现在错误接受区域和错误拒绝区域, 其中黑色区域为正确定位的区域。将错误接受率记作Far, 错误拒绝率记作Frr, 错误定位率记作Flr, 结合实际眼睑区域占比(记作Ter)来评估定位的准确性。如果将错误拒绝区域的面积记作Afr, 错误接受区域的面积记作Afa, 正确定位的区域面积记为Atl, 展开后图像的总面积记作Atotal, 则可以得到

| $ \left\{\begin{array}{l} F_{\mathrm{ar}}=\frac{A_{\mathrm{fa}}}{A_{\mathrm{total}}} \\ F_{\mathrm{rr}}=\frac{A_{\mathrm{fr}}}{A_{\text {total }}} \\ F_{\mathrm{lr}}=\frac{A_{\mathrm{fa}}+A_{\mathrm{fr}}}{A_{\text {total }}} \\ T_{\text {er }}=\frac{A_{\mathrm{tl}}+A_{\mathrm{fr}}}{A_{\text {total }}} \end{array}\right. $ | (1) |

2 结果与讨论

本文所用的所有虹膜图像, 均来自中国科学院开源的虹膜图像数据库(CASIA Iris Image Database)。训练和测试数据共7 000张, 每张图像都标注了5个点。其中, 训练数据共5 000张, 全部来自Casia-Iris-V4-Thousands。测试数据共2 000张, 其中1 000张来自Casia-Iris-V4-Thousands, 500张来自Casia-Iris-V3-Lamp, 另外500张来自Casia-Iris-V2-Device1。本文采用5%作为阈值, 若某张图像错误率大于5%, 则认为此图像定位不准确。在V4, V3, V2 3个库中错误定位的样本数分别为2个、7个、15个, 准确率分别为99.8%, 98.6%, 97.0%。

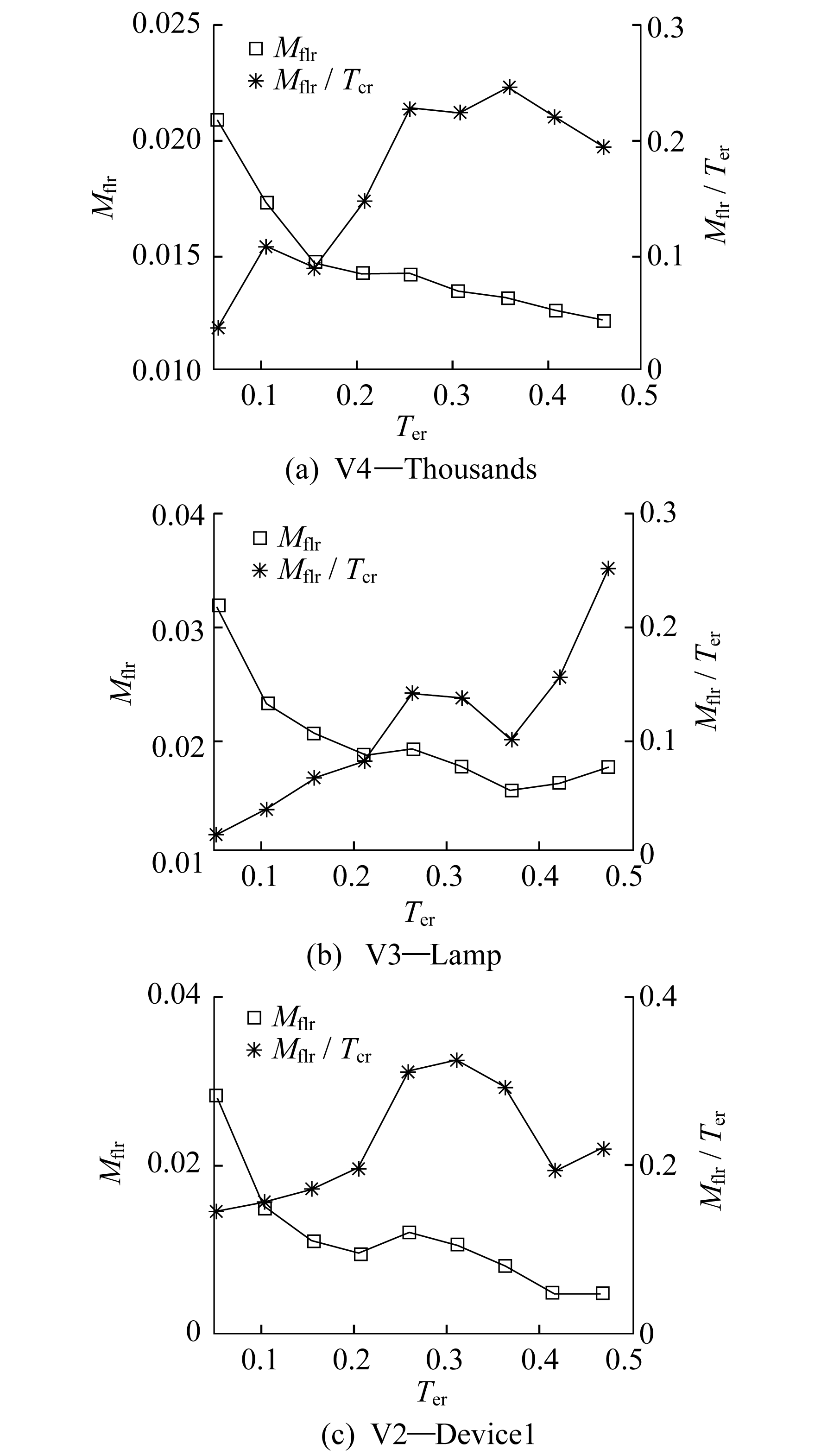

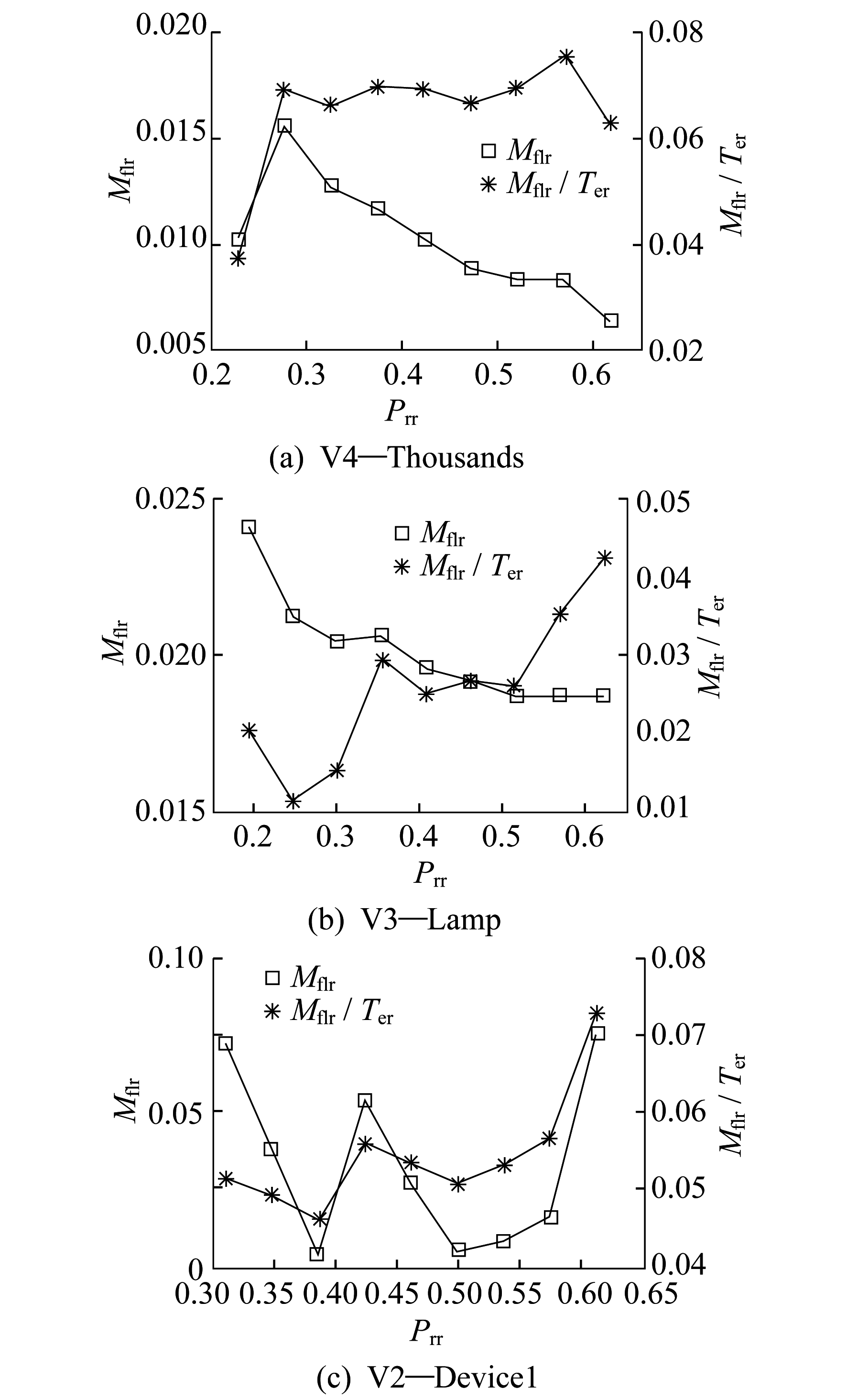

下面分析影响定位误差的因素。本文推测定位的误差可能受到Ter和瞳孔半径与虹膜半径的比例Prr的影响, 因此将Ter和Prr从小到大等分成9个区间, 计算每个区间内的平均定位误差率Mflr, 得到的结果如图 5和图 6所示。

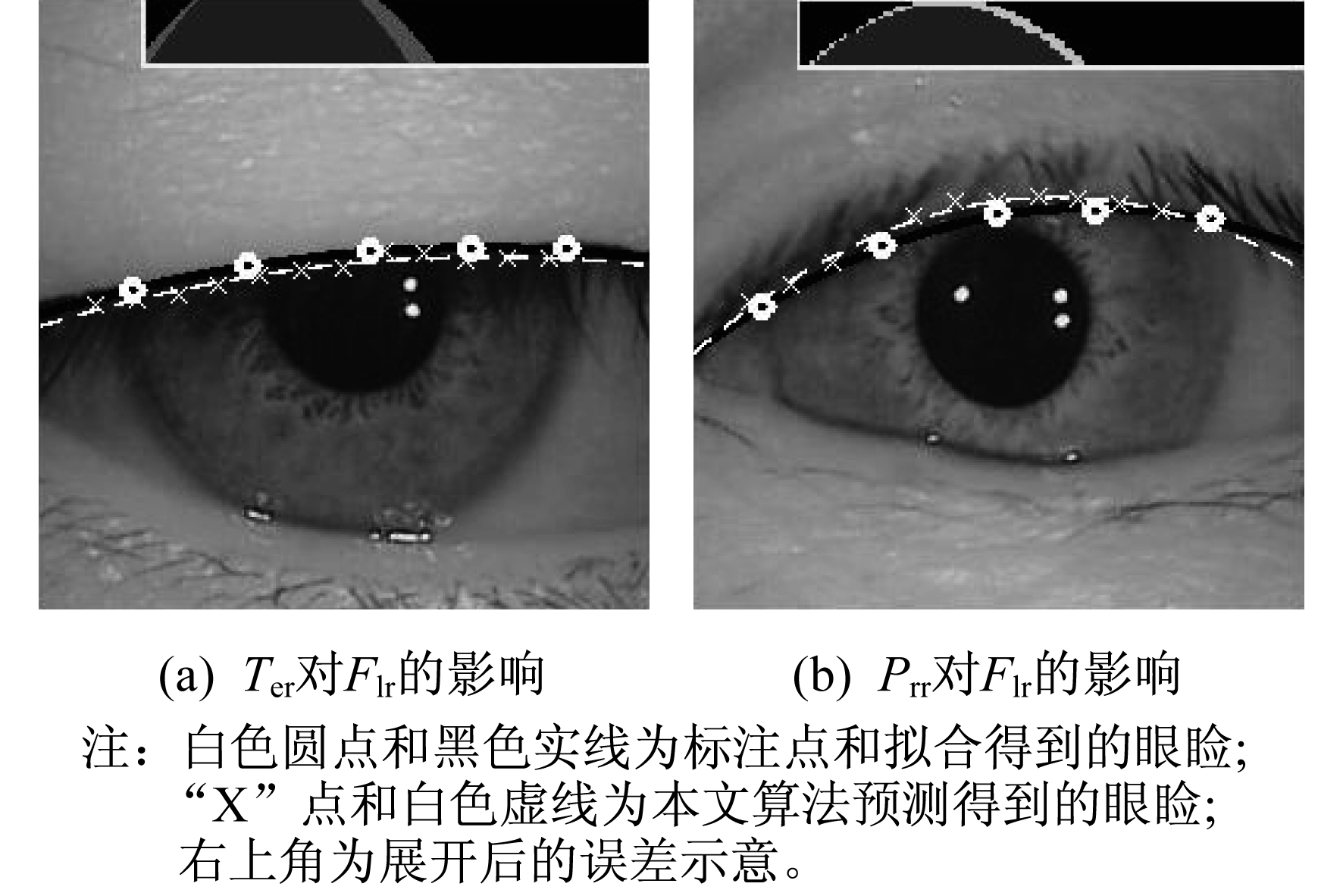

从图 5和图 6可以看出, 随着Ter和Prr的增加, Mflr显著增加。因此, 对于大瞳孔或眼睑遮挡严重的图像, 定位误差容易增大。究其原因, 一是由于进行了归一化操作, 将虹膜所在的环形区域展开成矩形时, 相对于远离瞳孔的区域, 靠近瞳孔的区域拉伸得更为严重, 提高了该区域的面积占比; 二是在一般情况下, 随着Ter的增加, 横轴方向上眼睑的固有长度也会增加, 对于相同的纵向定位误差, 自然就会出现更大的总体定位误差, 这一原理如图 7所示。

从图 7可以看出, 如果考虑标注带来的人为误差, 则这些图像可以被认为是正确的分类图像。

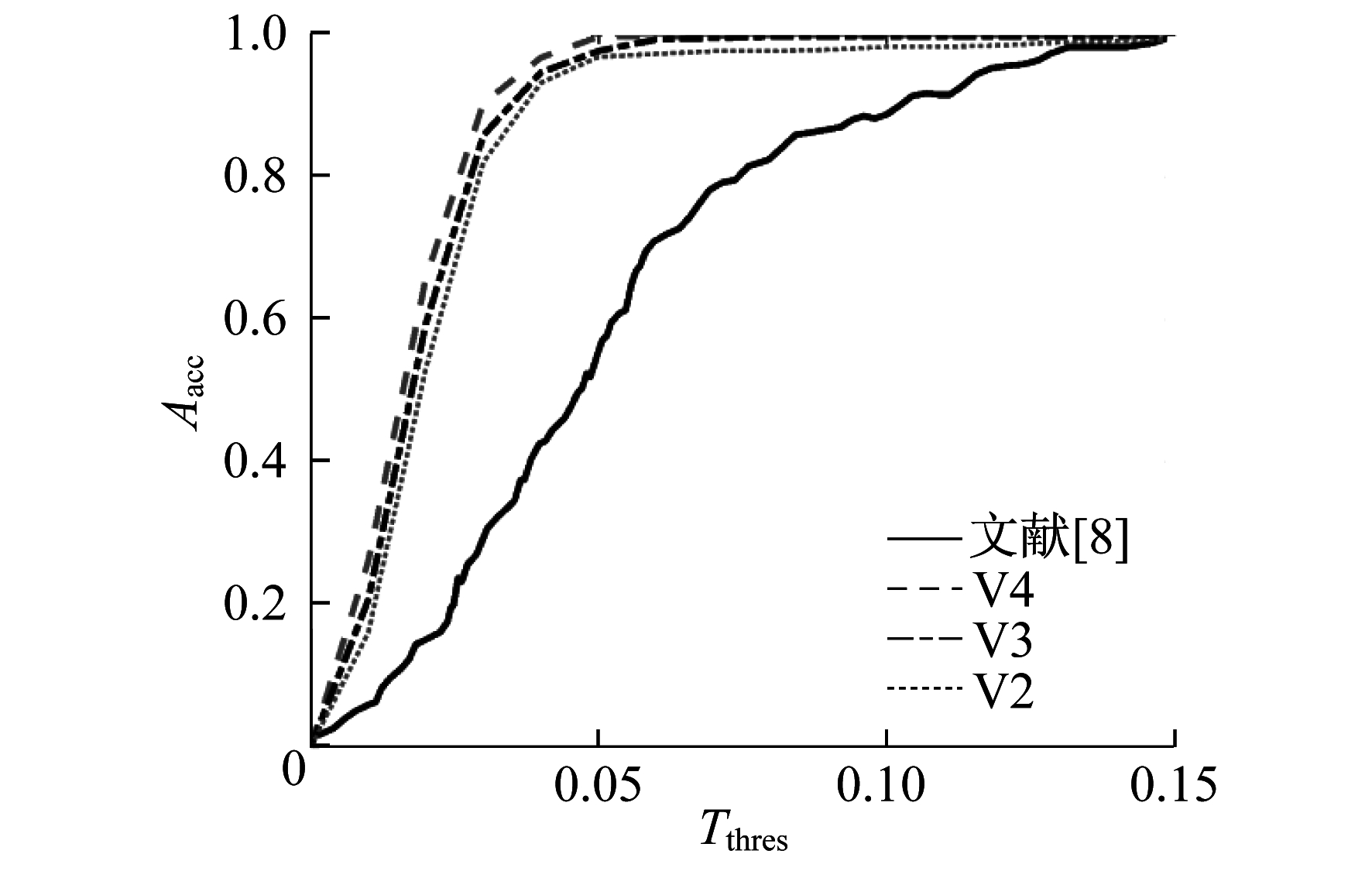

采用不同的阈值可以得到不同的准确率。不同阈值Tthres下得到的准确率Aacc, 以及与文献[8]所得出的准确率对比如图 8所示。

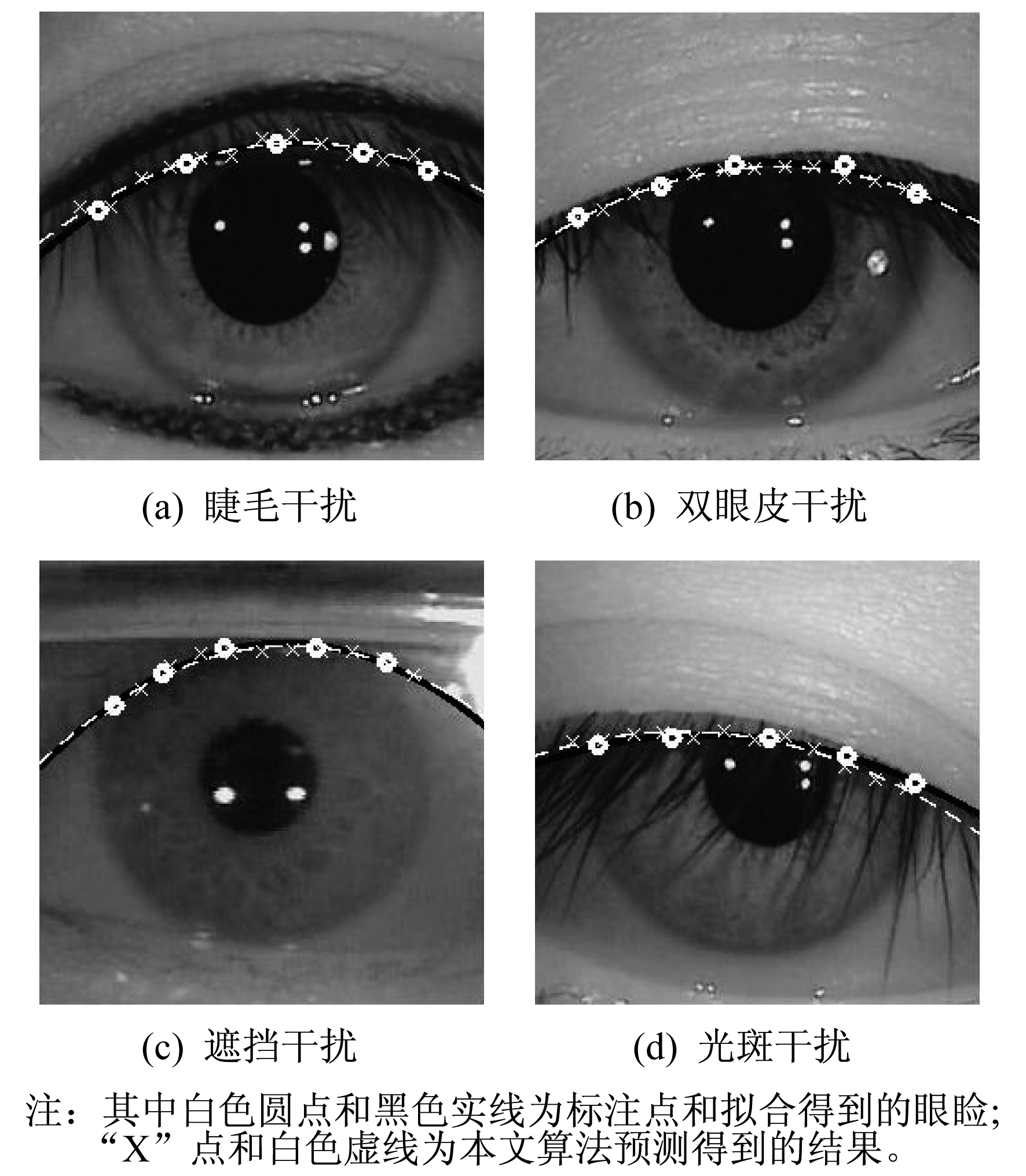

从图 8可以看出, 本文算法的准确率远高于文献[8]的准确率。当阈值为5%时, 文献[8]的准确率只有55.0%, 而本文算法的准确率可以达到97.0%, 98.6%, 99.8%。由于文献[8]采用的是Canny算子, 容易受到各种噪声干扰的影响, 泛化能力差, 因此效果不太理想。本文采用了特征提取能力更为强大的深度神经网络, 特征的抗干扰能力和泛化能力都很强, 即便是一些困难样本也能准确定位。部分定位效果如图 9所示。

由图 9可以看出, 本文算法在多种干扰下均可以得到较好的定位结果。本文的神经网络都是在Casia-Iris-V4-Thousands中训练的, 但也能够很好地泛化到Casia-Iris-V3-Lamp和Casia-Iris-V2-Device1中, 充分证明了本方法具有高准确率和强泛化能力。

4 结语

本文提出了一种基于深度卷积神经网络的上眼睑定位算法, 利用滑动窗口和EyelidNet网络获取精确的眼睑关键点, 并利用二次曲线进行拟合得到眼睑轮廓线。采用严格的标准对定位后的图像进行归一化处理, 并进行误差分析。结果表明, 本算法具有高准确率和强泛化能力, 对于部分困难样本仍能精确定位, 准确率达到97.0%以上。

参考文献

-

[1]MANSFIELD T, KELLY G, CHANDLER D, et al. Biometric product testing final report[J]. Contract, 2001, 92: 1-22.

-

[2]DAUGMAN J. How the afghan girl was identified by her iris patterns[EB/OL]. (2012-01-14)[2018-10-01]. http://www.cl.cam.ac.uk/-jgd1000/afghan.html.

-

[3]SUN Z, DONG W, TAN T. Technology roadmap for smart iris recognition[C]//GraphiCon-International Conference on Computer Graphics and Vision. Moscow: Graphicon Ru, 2008: 12-19.

-

[4]DAUGMAN J. New methods in iris recognition[J]. IEEE Transactions on Systems, Man, and Cybernetics, Part B(Cybernetics), 2007, 37(5): 1167-1175. DOI:10.1109/TSMCB.2007.903540

-

[5]DAUGMAN J. How iris recognition works[J]. Circuits and Systems for Video Technology IEEE Transactions on, 2004, 14(1): 21-30. DOI:10.1109/TCSVT.2003.818350

-

[6]WILDES R P, ASMUTH J C, GREEN G L, et al. A system for automated iris recognition[C]//Proceedings of the Second IEEE Workshop on Applications of Computer Vision. Piscataway, NJ: IEEE Press, 1994: 121-128.

-

[7]WILDES R P. Iris recognition: an emerging biometric technology[J]. Proceedings of the IEEE, 1997, 85(9): 1348-1363. DOI:10.1109/5.628669

-

[8]ADAM M, ROSSANT F, AMIEL F, et al. Eyelid localization for iris identification[J]. Radioengineering, 2008, 17(4): 82-85.

-

[9]HE Z, TAN T, SUN Z, et al. Toward accurate and fast iris segmentation for iris biometrics[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(9): 1670-1684. DOI:10.1109/TPAMI.2008.183

-

[10]LI H, SUN Z, TAN T. Robust iris segmentation based on learned boundary detectors[C]//5th IAPR International Conference on Biometrics. Piscataway, NJ: IEEE Press, 2012: 317-322.

-

[11]TAN T, HE Z, SUN Z. Efficient and robust segmentation of noisy iris images for non-cooperative iris recognition[J]. Image and Vision Computing, 2010, 28(2): 223-230. DOI:10.1016/j.imavis.2009.05.008

-

[12]SUN Y, WANG X, TANG X. Deep convolutional network cascade for facial point detection[C]//Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2013: 3476-3483.

-

[13]ZHANG Z, LUO P, LOY C C, et al. Facial landmark detection by deep multi-task learning[C]//European Conference on Computer Vision. Berlin: Springer, 2014: 94-108.

-

[14]REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031

-

[15]REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 779-788.

-

[16]LIU W, ANGUELOV D, ERHAN D, et al. SSD: single shot multibox detector[C]//European Conference on Computer Vision. Berlin: Springer, 2016: 21-37.

-

[17]LIU N, LI H, ZHANG M, et al. Accurate iris segmentation in non-cooperative environments using fully convolutional networks[C]//International Conference on Biometrics. Piscataway, NJ: IEEE Press, 2016: 1-8.

-

[18]JHA R R, THAPAR D, PATIL S M, et al. UBSegNet: Unified biometric region of interest segmentation network. [EB/OL]. (2017-09-26)[2018-10-01].https: //arxiv.org/abs/1709.08924v1.

-

[19]JALILIAN E, UHL A, KWITT R, et al. Domain adaptation for CNN based iris segmentation[C]//International Conference of the Biometrics Special Interest Group. Piscataway, NJ: IEEE Press, 2017: 1-6.

-

[20]BAZRAFKAN S, THAVALENGAL S, CORCORAN P. An end to end deep neural network for iris segmentation in unconstraint scenarios. [EB/OL]. (2017-12-25)[2018-10-01].https: //arxiv.org/abs/1712.01897.

-

[21]BHANU B, KUMAR A. Deep learning for biometrics[M]. Berlin: Springer, 2017: 133-153.

-

[22]ARSALAN M, HONG H G, NAQVI R A, et al. Deep learning-based iris segmentation for iris recognition in visible light environment[J]. Symmetry, 2017, 9(11): 263. DOI:10.3390/sym9110263

-

[23]HE Y, WANG S, PEI K, et al. Visible spectral iris segmentation via deep convolutional network[C]//Chinese Conference on Biometric Recognition. Berlin: Springer, 2017: 428-435.

-

[24]LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2015: 3431-3440.